Livre blanc

Transformation à la Edge

L'architecture de votre infrastructure pour la performance et la fiabilité

Examinez de plus près l'évolution de Edge Computing ainsi que les différents exemples, secteurs et cas d'utilisation où elle présente le plus d'avantages.

Pour de nombreux professionnels de la technologie opérationnelle (OT), l'évolution des Edge Computing peut sembler être une cible mouvante. Sur ce site white paper, découvrez des cas d'utilisation, des exemples et des secteurs dans lesquels Edge Computing apporte le plus d'avantages ainsi qu'une meilleure compréhension de l

- Avantages de Edge Computing

- Changement des exigences

- Nouvelles tendances, complications et opportunités pour Edge Computing

Alors que les tendances commerciales et technologiques continuent de remodeler la façon dont l'informatique est utilisée sur le site edge, il est essentiel de connaître la meilleure façon de sélectionner, de mettre en œuvre et de tirer parti des opportunités. Edge Computing opportunités.

Téléchargez le document white paper Transformation at the Edge: Architecting Your Infrastructure for Performance and Reliability aujourd'hui !

Résumé

De nombreuses entreprises se tournent vers leurs Edge Computing pour améliorer la manière dont elles collectent et traitent les données résultant de la croissance explosive des appareils connectés à Internet. Pourtant, pour la plupart des professionnels des technologies opérationnelles (OT) qui sont depuis longtemps responsables des systèmes informatiques basés sur edge dans leurs organisations, l'évolution de edge peut sembler être une cible mouvante.

Alors que les tendances commerciales et technologiques continuent de remodeler la façon dont l'informatique est utilisée sur le site edge, de nombreuses entreprises cherchent la meilleure façon de sélectionner, de mettre en œuvre et de tirer parti des opportunités qu'offrent aujourd'hui les stratégies d'avenir. Edge Computing offrent aujourd'hui.

Ce site white paper offre un regard plus approfondi sur Edge Computing et met en évidence divers exemples, secteurs et cas d'utilisation où elle présente le plus d'avantages. Il décrit également l'évolution en cours dans le secteur de l'informatique. Edge Computing Il montre également comment les solutions de nouvelle génération peuvent aider les entreprises à saisir les nouvelles opportunités offertes par la transformation du site edge, aujourd'hui et demain.

Bienvenue dans la nouvelle edge

Aujourd'hui, de nombreuses opérations et processus critiques se déroulent sur le site edge du réseau d'une organisation, comme les machines sans pilote, les systèmes de sécurité publique, les systèmes de transport et la production d'électricité et d'énergie. Ces opérations, et les équipements sur lesquels elles reposent, sont connectées à un nombre en croissance rapide de dispositifs de l'Internet des objets (IoT), qui devrait dépasser 29 milliards en 20301. Ces capteurs et appareils collectent des données en temps réel qui peuvent être utilisées pour rationaliser les cycles de production, améliorer la qualité des produits ou des services, ou raccourcir les temps de réponse. Par conséquent, une meilleure gestion des données edge peut aider l'ensemble de l'entreprise à améliorer les processus critiques, à réduire les coûts et à obtenir un avantage concurrentiel important.

Pourtant, il est plus difficile qu'il n'y paraît de tirer parti de ces avantages, surtout lorsqu'on tente de traiter et de gérer les données du site edge au moyen d'applications centralisées basées sur le site cloud ou de centres de données sur site. Bien que ces modèles informatiques aient leurs avantages, ils ne sont pas particulièrement adaptés au soutien d'environnements où le personnel informatique est limité, où la connectivité est faible ou coûteuse, et où les opérations sont particulièrement sensibles au facteur temps. Toutes ces conditions se retrouvent généralement sur le site edge.

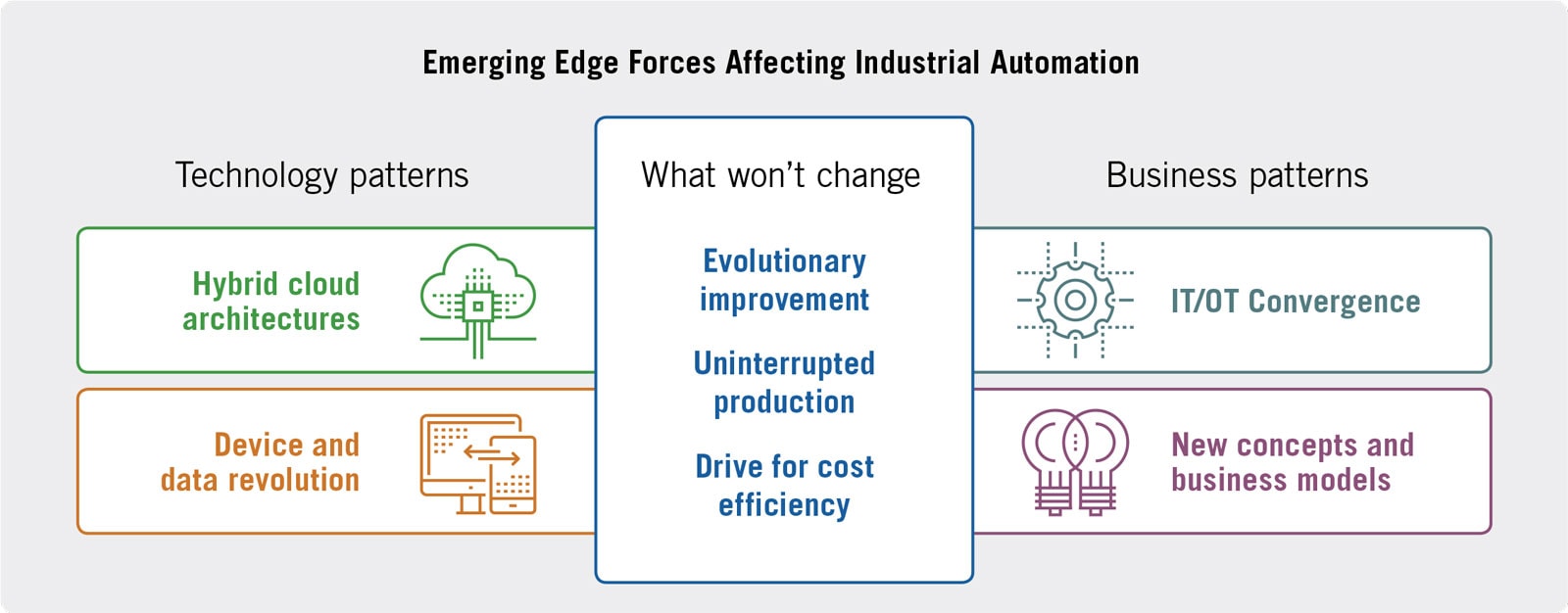

Edge Computing Le monde d'aujourd'hui est en train de vivre des changements significatifs, apportant de nouvelles pressions ainsi que de nouvelles opportunités qui, ensemble, sont à l'origine de la transformation rapide de ce qui se passe sur le site edge.

Le potentiel de la edge

Pour surmonter ces difficultés inhérentes, de nombreuses organisations ont commencé à repenser leurs infrastructures. Edge Computing infrastructures, qui ont généralement une connectivité limitée ou inexistante avec un site distant data center et/ou le site cloud. Les données Edge peuvent être traitées directement au point d'origine, ou être envoyées à un dispositif de mise en réseau de type passerelle ou à un serveur intermédiaire. Mais dans un cas comme dans l'autre, l'utilité des données est souvent restreinte par les limites d'échelle et de capacité du matériel - parfois vieux de 30 ans - qui constitue la plupart des infrastructures de edge .

Edge Computing Aujourd'hui, le secteur des télécommunications connaît des changements importants, à commencer par une utilisation accrue. Il en résulte de nouvelles pressions et de nouvelles opportunités qui, ensemble, sont à l'origine de la transformation rapide de ce qui se passe sur le site edge.

Pour les organisations qui tirent parti de ces possibilités, les retombées peuvent être considérables. Par exemple, les applications liées à l'analyse, aux feux de signalisation intelligents, aux communications entre véhicules, à la production d'énergie et aux équipements de fabrication bénéficient d'une infrastructure améliorée qui traite et utilise plus efficacement les données en continu provenant des dispositifs et capteurs IoT. Edge Computing d'une infrastructure améliorée qui traite et utilise plus efficacement les données en continu provenant de dispositifs et de capteurs IoT. Dans ces cas, ces applications peuvent réacheminer le trafic, améliorer la maintenance prédictive pour prévenir les défauts, et optimiser la production.

Avantages pour les professionnels de l'OT

Les professionnels de l'OT ont beaucoup à faire : En plus de veiller à ce que la chaîne de montage fonctionne, que l'eau coule ou que les trains soient à l'heure, ils doivent maintenant mettre à jour leurs systèmes d'IA pour tirer parti de l'évolution du site edge.

Une approche technologie plus service pour optimiser l'infrastructure edge peut grandement simplifier ce défi et apporter des avantages significatifs aux professionnels de l'OT et à leurs organisations. Ces avantages sont les suivants

- Atténuation des risques : L'absence de temps d'arrêt imprévu dans leurs systèmes d'AI aide les organisations à éviter les perturbations qui résultent de pannes de système, même brèves.

- Efficacité opérationnelle : La surveillance proactive, l'automatisation et une meilleure visibilité de chaque composant de leurs systèmes d'IA permettent aux professionnels de l'OT d'apporter rapidement des améliorations opérationnelles, ce qui leur permet de gagner du temps et de l'argent.

- Coût total de possession réduit : l'intégration de l'ensemble du matériel, des logiciels et des services nécessaires à la gestion des applications IA dans une solution unique et unifiée se traduit par le coût total de possession le plus bas pour une solution de haute disponibilité edge .

- Autonomisation de l'OT : La simplification de la gestion des architectures edge permet de réduire la dépendance des professionnels de l'OT vis-à-vis des services informatiques et leur donne les moyens de prendre la tête du déploiement des technologies dans leur sphère d'influence - vers l'IIoT et au-delà.

L'évolution des exigences de Edge Computing

Edge sont généralement déployés dans des endroits éloignés, au-delà du site typique data center ou, par définition, jusqu'au site edge des réseaux informatiques.

La simplicité est essentielle sur le site edge, mais des éléments tels que la facilité d'entretien et d'utilisation le sont tout autant. En général, les environnements edge reposent souvent sur des professionnels de l'OT - et non de l'IT - de sorte que si quelque chose ne va pas, l'idée de faire venir quelqu'un par avion pour le réparer n'est pas envisageable du point de vue du temps ou des coûts. Le personnel d'exploitation n'est peut-être pas spécialisé dans l'informatique, mais il est tout de même capable d'assurer la maintenance du produit et de le rendre opérationnel rapidement.

De nombreuses nouvelles applications edge contiennent une quantité importante de données ou les transmettent en continu à d'autres endroits, ce qui rend l'intégrité des données extrêmement importante. Toute défaillance peut entraîner une rupture du flux de données, ce qui pose plusieurs problèmes aux processus existants ou aux efforts de conformité. Par exemple, dans une exploitation laitière, si un système tombe en panne alors que le lait passe dans la chaîne de production, les agriculteurs risquent de ne pas pouvoir collecter les données requises pour la conformité, ce qui augmente le risque en cas de rappel potentiel.

Sur le site edge , les applications ne sont généralement pas mises à jour très souvent. Les entreprises ont donc besoin d'une technologie dotée d'un modèle de service et d'outils qui leur permettent de déployer le système et de le laisser essentiellement tranquille pendant très longtemps.

Nouvelles tendances, complications et opportunités

Les organisations qui utilisent le site edge aujourd'hui peuvent penser que leur approche actuelle est suffisante - pour le moment. Cependant, de nombreuses tendances et mutations technologiques sont en train de se produire, qui les obligeront à changer leur façon de penser et d'agir en ce qui concerne Edge Computing:

- Évolution du dispositif : L'augmentation des volumes fera baisser les coûts unitaires, ce qui rendra les appareils IdO moins chers, plus performants et standardisés. Par exemple, les contrôleurs logiques programmables (PLC) deviennent déjà plus intelligents, basés sur des normes ouvertes et beaucoup plus rentables.

- L'OT va évoluer : Le rôle de l'OT continuera d'évoluer car les départements informatiques sont déjà trop sollicités et le site edge n'est tout simplement pas une priorité pour eux. L'OT assumera davantage de responsabilités pour les technologies qui sont essentielles pour eux, telles que Edge Computing.

- Augmentation de l'automatisation par les machines : Les technologies émergentes telles que l'analyse en temps réel et l'intelligence artificielle augmenteront la criticité des données edge . D'ici 2025, 30 % des nouveaux systèmes de contrôle industriel comprendront des capacités d'analyse et d'inférence de l'IA-edge 2. L'automatisation deviendra de plus en plus rapide et beaucoup plus performante, dépassant même les limites des capacités humaines. Par exemple, les chemins de fer peuvent désormais traiter les données edge pour permettre des déplacements à 300 km par heure en toute sécurité.

- Nouveaux fournisseurs et nouveaux modèles commerciaux : Les nouvelles solutions technologiques, telles que l'IA, l'apprentissage machine et l'analyse avancée, continueront à favoriser l'innovation, l'agilité et l'efficacité du capital. Les organisations doivent envisager des partenariats avec les fournisseurs, les technologies et les solutions les mieux adaptées à leurs stratégies à long terme.

Il est clair que le fonctionnement sur le site edge continuera à exiger de nouvelles façons de penser et d'agir. Ces tendances doivent être soigneusement évaluées par toute organisation déployant une Edge Computing stratégie.

Les solutions actuelles ne sont pas à la hauteur

Il est largement reconnu que les systèmes actuels basés sur edge ont besoin de nouvelles technologies habilitantes pour répondre à l'évolution de la demande. Cependant, l'offre de ces technologies ne répond pas aux besoins.

Il existe des technologies informatiques/communications qui s'adressent au secteur de l'automatisation industrielle (IA). Cependant, elles ont tendance à se concentrer sur les besoins des clients utilisateurs finaux de l'IA depuis des décennies, plutôt que sur les pressions spécifiques à edge(telles que la nécessité d'effectuer une maintenance prédictive ou de s'intégrer à l'analyse du Big Data) qui stimulent le domaine de l'IA aujourd'hui. En tant que tels, ils représentent une combinaison sous-optimale de capacités et de lacunes.

Voici quelques exemples de ces technologies :

- Lesordinateurs de réseau IA des fournisseurs de centres de données traditionnels, tels que les passerelles Dell Edge pour l'IdO, peuvent collecter des données à partir de capteurs ou de dispositifs sur le site edge et les envoyer à un data center ou à un cloud public. Elles sont moins coûteuses que les autres catégories de solutions edge , mais ne sont pas très évolutives (par opposition à l'évolution vers l'extérieur) et n'offrent pas une disponibilité continue ou une simplicité opérationnelle, deux éléments essentiels sur le site edge.

- Lesplates-formes hyperconvergées, telles que les systèmes convergents Edge de Hewlett Packard Enterprise, intègrent des capacités de saisie, de contrôle, de calcul et de stockage des données dans un seul dispositif matériel. Elles mettent l'accent sur la simplicité opérationnelle et peuvent effectuer des analyses en temps réel sur le site edge, mais au prix d'une disponibilité continue et d'un coût abordable.

- Les solutions de haute disponibilité s'appuient sur la virtualisation pour offrir des niveaux de disponibilité plus élevés à un coût acceptable, mais elles sacrifient la simplicité opérationnelle en exigeant des compétences de niveau informatique. Nombre d'entre elles n'ont pas non plus la puissance et les performances de calcul requises pour la synthèse et l'analyse des données en temps réel.

Il est clair que les systèmes de contrôle industriel vieux de 30 ans qui sont encore la norme dans de nombreux environnements de fabrication et d'IA ont besoin d'une mise à niveau substantielle pour passer à l'Internet industriel des objets, aux clouds omniprésents et/ou à l'informatique en brouillard. Toutefois, l'approche consistant à remplacer les systèmes par d'autres ne fonctionnera pas. Les défis auxquels ces entreprises sont confrontées pendant leur transition vers le site edge consistent notamment à continuer de collecter des données à partir de leurs systèmes legacy , à prolonger le cycle de vie de ces systèmes dans la mesure du possible et à ajouter progressivement des capacités.

edge En outre, toutes les entreprises n'ont pas besoin d'aller jusqu'au bout du continuum de edge. Leurs besoins commerciaux détermineront l'ampleur de la transformation dont elles ont besoin. Cependant, pour qu'une organisation puisse tirer le maximum d'avantages de l'évolution de edge , une nouvelle approche technologique est nécessaire.

Les systèmes de contrôle industriel vieux de 30 ans qui sont encore la norme dans de nombreux environnements de fabrication et d'IA ont besoin d'une mise à niveau substantielle pour passer à l'Internet industriel des objets, aux clouds omniprésents et/ou au fog computing. Toutefois, l'approche consistant à remplacer les systèmes par d'autres ne fonctionnera pas.

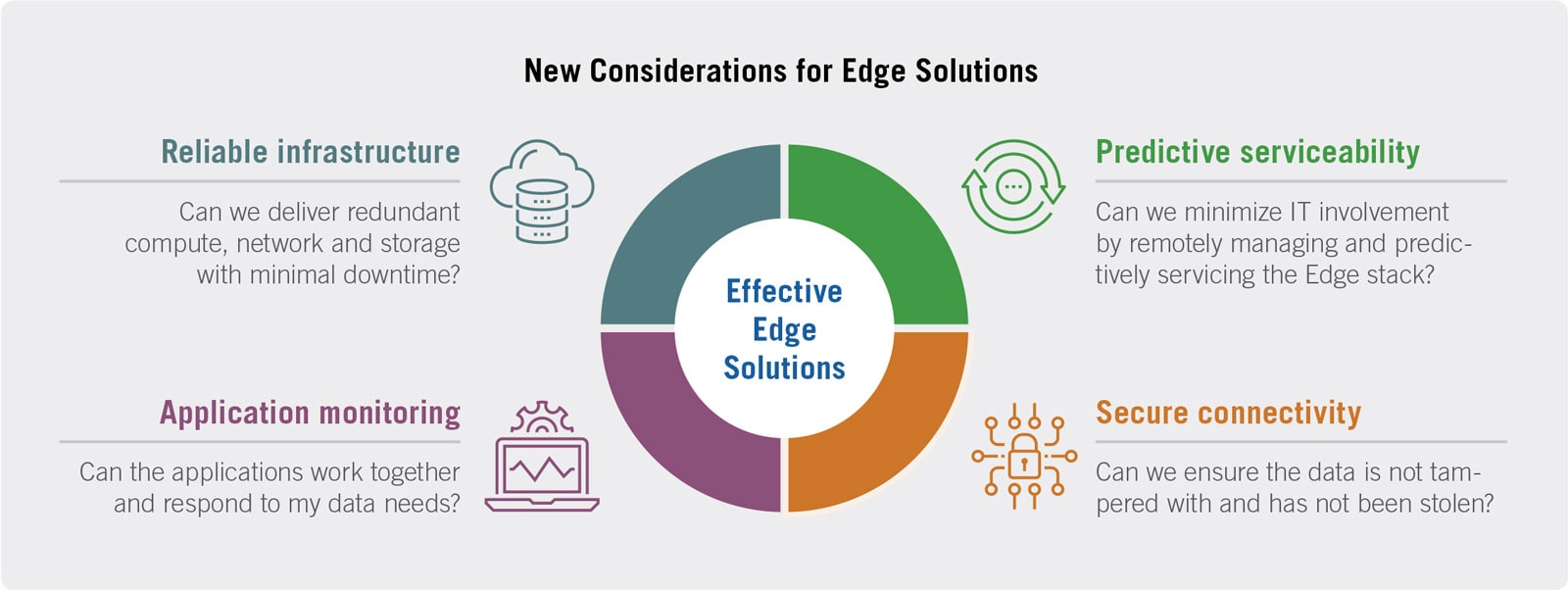

La solution idéale

Pour pallier ces insuffisances, une solution idéale répondrait aux besoins des entreprises edge en matière de calcul haute performance fiable et évolutif. En outre, elle offrirait ces avantages à court terme et répondrait aux exigences actuelles, tout en s'adaptant à une infrastructure edge en évolution.

Plus précisément, les attributs essentiels pour un déménagement vers le site edge sont les suivants :

- Unesimplicité opérationnelle qui permet un fonctionnement, une facilité d'entretien et une facilité d'utilisation sans contact ou presque - autant d'éléments essentiels étant donné que les ressources informatiques sont rares sur le site edge ou dans l'usine.

- Uneproduction ininterrompue pour éviter les temps d'arrêt non planifiés, ainsi que la garantie de l'intégrité des données, car les nouvelles applications edge contiennent de gros volumes de données ou transmettent des données en continu à des sites distants (comme cloud).

- Descapacités de virtualisation et de fiabilité qui permettent aux fabricants et aux organisations d'IA de déployer des systèmes et des bases de données critiques hautement disponibles - et pourtant très efficaces.

- Lesconceptions d'interopérabilité qui tirent parti des normes actuelles (par exemple, les systèmes d'exploitation) ainsi que des normes émergentes qui permettront aux dispositifs et aux systèmes de fonctionner les uns avec les autres.

- la cybersécurité, qui comprend la protection intégrée de tous les composants du système, des données qu'ils manipulent et de leurs communications entre eux et avec l'extérieur. Edge Computing système, des données qu'ils traitent et de leurs communications entre eux et avec l'extérieur.

Un exemple d'architecture et de livraison optimisées edge.

Aujourd'hui, les fournisseurs de technologies de pointe proposent une nouvelle approche innovante de l'infrastructure edge qui intègre tous les attributs décrits ci-dessus. Qui plus est, cette solution est complète - une plateforme informatique complète et clé en main qui permet aux entreprises d'IA de mettre à jour les systèmes vieillissants, de virtualiser les applications de contrôle industriel et d'accroître l'efficacité opérationnelle.

Cette nouvelle approche edge se compose de trois éléments essentiels :

- Une plateforme informatique sans contact : Une plate-forme informatique industrielle automatisée, entièrement intégrée et autoprotégée qui réduit le besoin de support informatique tout en augmentant l'efficacité des opérateurs et en réduisant les risques d'interruption de service.

- Infrastructure définie par logiciel edge : Une interface unique vers une pile complète d'applications essentielles, notamment le calcul, le stockage et la mise en réseau virtualisés, la cybersécurité, les passerelles IoT, les VPN, les routeurs, l'analytique et l'intelligence artificielle.

- Un service géré proactif : Une approche révolutionnaire du déploiement, de la surveillance et de la maintenance des solutions et de l'infrastructure edge . Contrairement au service réactif d'hier, un tel service géré de manière proactive peut être facilement supervisé par des professionnels de l'OT, exécuté par le système lui-même et soutenu par un seul fournisseur de services basé localement.

La combinaison de ces trois éléments - une plateforme informatique sans contact, l'infrastructure définie par logiciel edge et un service géré proactif - crée une nouvelle solution d'infrastructure optimisée pour les organisations sur le site edge.

Les principaux avantages de la solution optimisée sont les suivants :

- Il est idéal pour exécuter rapidement et de manière fiable des applications industrielles critiques dans des endroits éloignés, avec des ressources informatiques limitées ou inexistantes.

- Il augmente l'efficacité opérationnelle grâce à un logiciel de virtualisation préinstallé et à des outils de configuration et de gestion intuitifs et conviviaux.

- Il est facile à déployer et peut être installé rapidement par les utilisateurs, ce qui réduit le temps nécessaire à la mise en place et au fonctionnement des applications critiques.

- Il réduit la charge des TI grâce à des capacités d'autosurveillance et d'autoprotection qui le rendent idéal pour les installations sans personnel.

- Il permet d'éviter de manière prédictive les temps d'arrêt imprévus, grâce à des systèmes redondants sur site soutenus par un service géré cloud.

- Il supporte de multiples écosystèmes - un large éventail d'architectures et d'applications, sans modification.

Une telle plate-forme complète edge répond aux exigences essentielles de l'environnement actuel edge (voir la section "Les solutions actuelles ne sont pas à la hauteur"), notamment la simplicité opérationnelle, la virtualisation, la production ininterrompue et l'interopérabilité.

1Statista, Nombre d'appareils connectés à l'Internet des objets (IoT) dans le monde de 2019 à 2030, 8 juin 2022.

2Gartner, Market Guide for Edge Computing Solutions for Industrial IoT, 18 décembre 2020.

À propos de Stratus Technologies

Stratus simplifie le fonctionnement des applications critiques pour l'entreprise, 24 heures sur 24, 7 jours sur 7 et 365 jours par an. Les technologies de Stratuspermettent d'éviter de manière proactive les temps d'arrêt non planifiés, tant sur le site data center que sur le site edge, et nos services garantissent que les problèmes sont résolus avant que les clients n'en aient besoin. Depuis plus de 35 ans, les entreprises du classement Fortune 500 et les petites et moyennes entreprises dans un large éventail d'industries à travers le monde font confiance à Stratus pour une disponibilité continue et simple sur le plan opérationnel.

Pour plus d'informations, veuillez consulter le site www.stratus.com ou suivre sur Twitter @StratusAlwaysOn.